Ewolucja wyświetlaczy komputerowych

Przygotowano w oparciu o: Edwards, B. (2019). [VC&G Anthology] The Evolution of Computer Displays. Vintage Computing and Gaming. http://bit.ly/antologyVCG

Pewnym ograniczeniem pierwszych maszyn cyfrowych był brak możliwości komfortowego przeglądania wyników pracy takiej maszyny. Komunikowały one stan postępu prac za pomocą migających kontrolek lub kart dziurkowanych. Były to jednak rozwiązania mało użyteczne. Przodkami dzisiejszych wyświetlaczy ciekłokrystalicznych są lampy katodowe. Na ich podstawie konstruowano proste wyświetlacze monochromatyczne.

Migające kontrolki

Podczas gdy prawie każdy wczesny komputer umożliwiał wydruk na papierze, w pierwszych dniach „cyfrowych wyświetlaczy komputerowych” dominowały rzędy migających lampek kontrolnych (ryc. 1). Niewielkie żarówki migały, gdy określone instrukcje były przetwarzane lub dostępne było miejsce w pamięci. Poprzez „miganie” raportowany był bieżący status systemu. Kontrolki pokazywały co działo się „wewnątrz maszyny”, chociaż możliwość interpretacji wyników była ograniczona.

Rycina 1. MITS Altair 8800 (CPU: Intel 8080, 2.0 MHz)

Rycina 1. MITS Altair 8800 (CPU: Intel 8080, 2.0 MHz)

Źródło: oldcomputers.net

Punch Cards In, Punch Cards Out

W pierwszym programowalnym komputerze ENIAC wykorzystywano karty dziurkowane H. Holleritha (amerykański wynalazca), jako nośnik „wejścia/wyjścia”. Zarówno instrukcje, jak i wyniki prac maszyny były drukowane na kartach papierowych. Aby napisać program operator posługiwał się urządzeniem podobnym do maszyny do pisania, które kodowało instrukcje poprzez wycinanie otworów na karcie papieru. Następnie plik kart był „wrzucany” do komputera, który odczytywał i uruchamiał program. Wyniki były „dziurkowane” na pustych kartach, które były następnie dekodowane za pomocą urządzenia takiego jak tabulator IBM 405. Dekoder przetwarzał karty dziurkowane i drukował wyniki, które można było odczytać.

Dekodowanie taśmy papierowej

Alternatywą dla kart dziurkowanych były rolki taśmy papierowej, dziurkowanej według wzoru, którego interpretacja uruchamiała program komputerowy. W ten sam sposób komputer zwracał wyniki, tj. drukując ja na taśmie papierowej tego samego rodzaju. Następnie operator przepuszczał taśmę przez urządzenie odczytu, a elektroniczna maszyna do pisania przekształcała dane na treści w postaci czytelnej dla człowieka (cyfry i litery), drukowane na rolkach papieru.

Wczesne wyświetlacze CRT

Pierwsze lampy katodowe (cathode-ray tube, CRT) znalazły zastosowanie w komputerach jako forma „pamięci masowej”, np. „tuba Williamsa-Kilburna”. Inżynierowie szybko dostosowali lampy katodowe radarowe i oscyloskopowe, tak aby mogły one służyć jako prymitywne wyświetlacze monochromatyczne, np. jak w systemie SAGE (wektor rysowania pociągnięć) i PDP-1 (wykres punktowy, ryc. 2).

Przykładowo w polskiej maszynie cyfrowej ZAM-2 (1960) do bezpośredniej wymiany informacji między programistą a maszyną służył stolik operatora, zwany także pulpitem sterująco-kontrolnym. Pulpit operatora był wyposażony w monitory pamięci wykonane na lampie oscyloskopowej. Obserwacja monitorów w czasie biegu maszyny dostarczała niewielu informacji. Dokładna wartość rejestrów mogła być odczytana tylko po zatrzymaniu maszyny.

Rycina 2. Screenshot of a PDP-1 computer running Spacewar

Rycina 2. Screenshot of a PDP-1 computer running Spacewar

Licencja: Creative Commons Attribution 2.0 Generic. Źródło: wikimedia.org

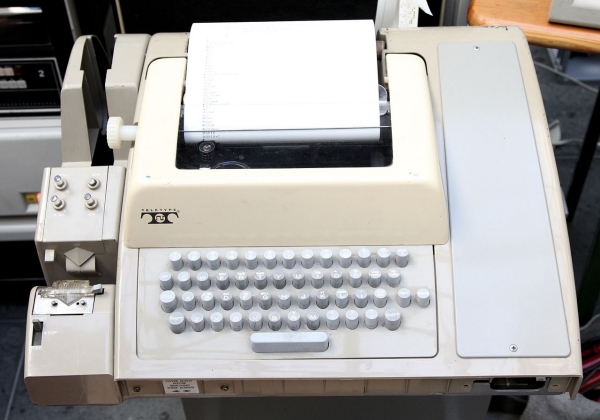

Era Teletype

Przed wynalezieniem komputera używano teletypów do komunikowania się za pośrednictwem linii telegraficznych (ryc. 3). Teletype (dalekopis) to elektroniczna maszyna do pisania (ryc. 4), która komunikuje się z innym teletypem za pomocą przewodów i specjalnego kodu, później także radiowo. W latach pięćdziesiątych inżynierowie podłączali teletypy do komputerów, aby używać ich jako „urządzeń wyświetlających”. Teletypy zapewniały ciągły wydruk sesji komputera i pozostały najtańszym sposobem komunikacji z komputerem do połowy lat siedemdziesiątych XX wieku.

Rycina 3. Teletyp w komputerze Univac 9400

Rycina 3. Teletyp w komputerze Univac 9400

Źródło: Computer History Museum

Rycina 4. Teletype terminal

Rycina 4. Teletype terminal

Licencja: CC BY-SA 4.0. Źródło: wikimedia.org

Szklany teletyp [The Glass Teletype]

Na początku lat 60. XX wieku inżynierowie zdali sobie sprawę, że mogą używać CRT jako „wirtualnego papieru” w wirtualnym teletypie (stąd termin „szklany teletyp” – wczesna nazwa takich terminali, jak np. DEC VT100 terminal [1978], ryc. 5). Oczywiście wyświetlacze wideo okazały się znacznie szybsze i bardziej elastyczne niż papier; takie terminale stały się dominującą metodą komunikacji z komputerami na początku lat 70. XX wieku. Były to urządzenia podłączone do komputerów za pomocą kabla, który zwykle przesyłał tylko kod znaków tekstowych – przeważnie bez grafiki, chociaż niektóre miały taką możliwość dzięki specjalnym protokołom tekstowym. Niewiele terminali CRT obsługiwało kolory aż do lat 80.

Rycina 5. DEC VT100 terminal

Rycina 5. DEC VT100 terminal

Licencja: CC BY-SA 3.0. Źródło: wikimedia.org

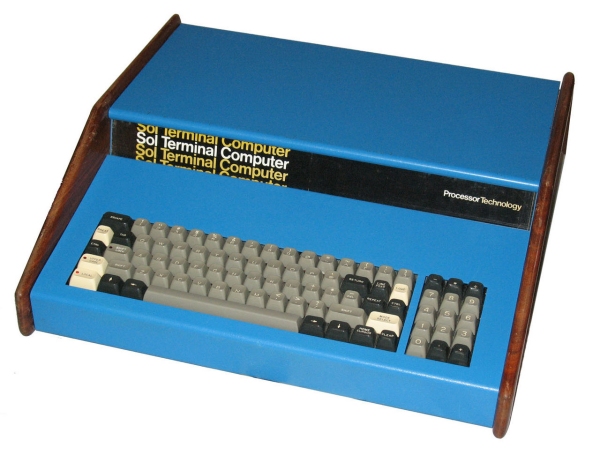

Kompozytowe wyjście wideo (Composite Video Out)

Teletypy (nawet te klasyczne) kosztowały w 1974 roku fortunę, dlatego też były daleko poza zasięgiem gospodarstw domowych. Poszukując tańszych alternatyw, trzech ludzi (Don Lancaster, Lee Felsenstein i Steve Wozniak) wpadło na ten sam pomysł w tym samym czasie: dlaczego nie zbudować taniego urządzenia końcowego z niedrogim monitorem wideo CCTV (Closed-Circuit TeleVision), który pełniłby rolę wyświetlacza? Wkrótce Wozniak i Felsenstein wbudowali takie terminale wideo bezpośrednio w komputery (np. Apple I i Sol-20, ryc. 6), tworząc w 1976 roku pierwsze urządzenia z fabrycznymi wyjściami wideo.

Rycina 6. Processor Technology SOL-20 Computer

Rycina 6. Processor Technology SOL-20 Computer

Licencja: public domain. Źródło: wikimedia.org

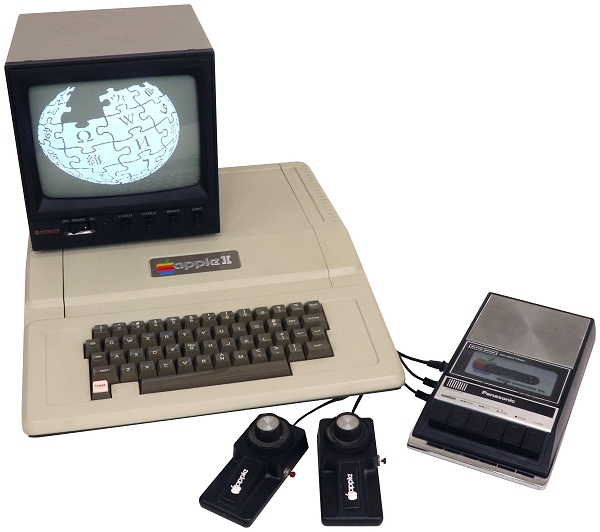

Wyświetlacze TV – monitor w każdym domu

Dzięki wyjściom wideo pojawiła się możliwość używania zwykłych telewizorów jako monitorów komputerowych. Zapoczątkowało to produkcję modulatorów RF (częstotliwości radiowych) dla Apple II (ryc. 7), które przekształcały kompozytowe wideo w sygnał symulujący transmisję bezprzewodową – coś, co mógł „zrozumieć” telewizor.

Rycina 7. Apple II in typical 1977 configuration with 9″ monochrome monitor

Rycina 7. Apple II in typical 1977 configuration with 9″ monochrome monitor

Licencja: CC BY-SA 4.0. Źródło: wikimedia.org

Komputer Atari 800 (1979), podobnie jak ówczesne konsole do gier, posiadał wbudowany modulator RF. Wielu innych producentów szybko zrobiło to samo, np. Commodore (ryc. 8). Jednak ograniczenia przepustowości i niedoskonałości obrazu w telewizorach konsumenckich ograniczały użyteczną moc wyjściową do niskich rozdzielczości, zatem w „poważnych” komputerach unikano zastosowania telewizorów na rzecz dedykowanych monitorów.

Rycina 8. Commodore 1702 Monitor

Rycina 8. Commodore 1702 Monitor

Licencja: CC BY-SA 2.0. Źródło: wikimedia.org

Monitory kompozytowe (More Composite Monitors)

Oprócz wyjścia telewizyjnego RF wiele wczesnych komputerów domowych obsługiwało kompozytowe monitory wideo, aby uzyskać obraz wyższej jakości (ryc. 9). Commodore 1702 oferował również alternatywny wyświetlacz wyższej jakości dzięki połączeniu typu S-Video.

Rycina 9. AppleColor Composite Monitor

Rycina 9. AppleColor Composite Monitor

Licencja: public domain. Źródło: wikimedia.org

Gdy rewolucja PC nabrała rozpędu twórcy komputerów, tacy jak Apple, Commodore, Radio Shack oraz TI, zaczęli projektować i sprzedawać monitory wideo – zarówno monochromatyczne, jak i kolorowe, w szczególności dla własnych systemów komputerowych. Większość z tych monitorów było uniwersalnych tzn. możliwe było ich zastosowanie pomiędzy systemami.

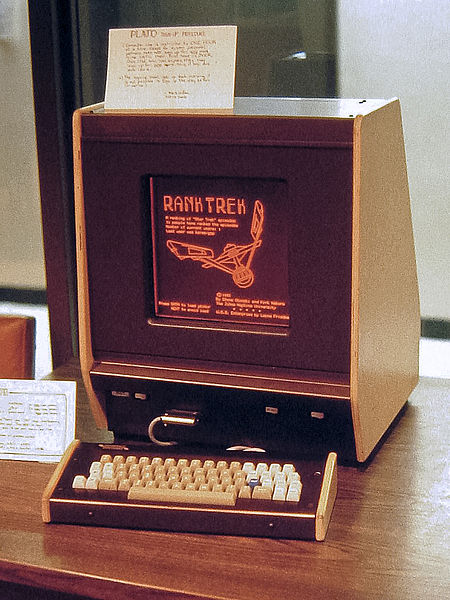

Wczesne wyświetlacze plazmowe

W latach 60. XX wieku pojawiła się alternatywna technologia wyświetlania, która wykorzystywała, w uproszczeniu, naładowany gaz zamknięty pomiędzy dwiema szklanymi płytkami. Kiedy wybrane miejsca traktowano ładunkiem elektrycznym pojawiał się świecący wzór. Jednym z pierwszych urządzeń komputerowych, które wykorzystywały wyświetlacz plazmowy był terminal PLATO IV (ryc. 10).

Rycina 10. PLATO V Terminal with plasma display 1981

Rycina 10. PLATO V Terminal with plasma display 1981

Licencja: CC BY 3.0. Źródło: wikimedia.org

Firmy takie jak IBM i GRiD eksperymentowały ze stosunkowo cienkimi, lekkimi wyświetlaczami w komputerach przenośnych. Technologia ta nigdy nie znalazła zastosowania w komputerach typu PC, ale pojawiła się ponownie po latach w płaskich telewizorach.

Wczesna era LCD

W latach 60. XX wieku pojawiła się kolejna alternatywna technologia wyświetlania – wyświetlacz ciekłokrystaliczny (liquid-crystal display, LCD), który po raz pierwszy zadebiutował na rynku w latach 70. XX wieku w kalkulatorach kieszonkowych i zegarkach na rękę. Pierwsze wyświetlacze LCD znalazły zastosowanie w przenośnych komputerach z lat 80. ponieważ były wyjątkowo energooszczędne, lekkie i cienkie, w porównaniu do rozwiązań alternatywnych. Wczesne monitory LCD były tylko monochromatyczne, miały niski kontrast i wymagały osobnego podświetlenia lub bezpośredniego oświetlenia, aby możliwe było odczytanie treści.

Wczesne wyświetlacze IBM PC

IBM PC (1981) był dostarczany w zestawie z monochromatycznym wyświetlaczem wideo typu MDA (Monochrome Display Adapter), który rywalizował z terminalem wideo pod względem ostrości. Do grafiki kolorowej IBM zaprojektował adapter CGA (Color Graphics Adapter), który umożliwiał podłączenie monitora wideo lub wyświetlacza IBM 5153. W 1984 roku IBM wprowadził technologię EGA (Enhanced Graphics Adapter), która przyniosła ze sobą wyższe rozdzielczości, więcej kolorów i oczywiście nowe monitory (ryc. 11).

Rycina 11. IBM PC XT 5160 Dual Floppy Drives with 5153 Color Monitor

Rycina 11. IBM PC XT 5160 Dual Floppy Drives with 5153 Color Monitor

Licencja: CC BY 4.0. Źródło: wikimedia.org

Wyświetlacze komputerów Macintosh

Pierwszy komputer Macintosh (1987) posiadał 9-calowy monitor monochromatyczny, który renderował bitmapę grafiki 512×342 na komputerze Mac w kolorze czarnym lub białym (brak odcieni szarości). Dopiero Macintosh II (1987) obsługiwał kolorowe wideo. Standard wideo Mac II był podobny do VGA (Video Graphics Array). Monitory komputerów Mac były powszechnie znane ze swojej ostrości i dokładnego odwzorowania kolorów.

Rycina 12. Macintosh SE with dual floppy drives

Rycina 12. Macintosh SE with dual floppy drives

Licencja: CC BY-SA 2.5. Źródło: wikimedia.org

RGB na ratunek

W latach 80. XX wieku pojawiły się na rynku zarówno komputery Macintosh, jak i IBM PC, które szczyciły się ostrą, kolorową grafiką w wysokiej rozdzielczości. Zarówno seria Atari ST, jak i seria Commodore Amiga były wyposażone w monitory monochromatyczne i monitory RGB, które pozwalały w pełni cieszyć się grafiką komputerową.

Dwie ważne innowacje: Multisync i VGA

Na początku komputer IBM wymagał innego monitora dla każdego schematu wyświetlania – MDA, CGA, EGA i innych. Aby rozwiązać ten problem NEC (NEC Display Solutions) wynalazł pierwszy monitor wielosynchroniczny (zwany „MultiSync”), który obsługiwał zróżnicowany zakres rozdzielczości, częstotliwości skanowania i częstotliwości odświeżania. Ta zdolność wkrótce stała się standardem w branży.

W 1987 roku IBM wprowadził standard wideo VGA i pierwsze monitory VGA w powiązaniu z linią komputerów PS / 2 IBM. Prawie każdy analogowy standard wideo od tego czasu opiera się na VGA, i znanym 15-pinowym złączu.

LCD w laptopach

W latach 80. i 90. XX wieku technologia LCD rozwijała się dynamicznie, napędzana boomem na rynku komputerów przenośnych. Wyświetlacze LCD zyskały większy kontrast, lepsze kąty widzenia, zaawansowane możliwości kolorystyczne i podświetlenie.

Era Beige Box

Połowa lat 90. XX wieku to era niedrogich, kolorowych, wielosynchronicznych monitorów VGA, które mogły obsługiwać szeroki zakres rozdzielczości. Producenci w tym czasie rozpoczęli eksperymenty z rozmiarem (od 14 do 21 cali i więcej) i kształtem monitorów (proporcje 4:3 lub pionowe wyświetlacze całej strony). Ponadto pod koniec lat 90. XX wieku dostępne stały się płaskie kineskopy.

Wczesne pulpity LCD

W latach 80. XX wieku firmy komputerowe niewiele eksperymentowały z monitorami LCD. Monitory te były wtedy bardzo drogie i miały niską wydajność w porównaniu do CRT (brak koloru, niski kontrast, niska częstotliwość odświeżania, niska rozdzielczość). Zmieniło się to około 1997 roku, kiedy „nagle” wielu dostawców, takich jak Dell, IBM czy Apple, wprowadziło kolorowe monitory LCD o jakości, która mogła konkurować z monitorami CRT za rozsądną cenę. Nowe monitory LCD zajmowały mniej miejsca, pobierały mniej prądu i generowały znacznie mniej ciepła niż CRT, co czyniło je atrakcyjnymi dla użytkowników.

Teraźniejszość i przyszłość

Obecnie monitory LCD są standardem w branży komputerów osobistych. W ostatnim czasie potaniały do tego stopnia, że wiele osób eksperymentuje z konfiguracją dwóch lub wielu monitorów podpiętych do jednego komputera. Monitory LCD przeważnie podłączane są do komputerów za pomocą cyfrowych łączy, takich jak DVI (ryc. 13 Digital Visual Interface) i HDMI (High Definition Multimedia Interface). Najnowszym trendem w branży są monitory obsługujące 3D za pomocą specjalnych okularów i bardzo wysokich częstotliwości odświeżania.

Rycina 13. Złącza, odpowiednio od lewej: DVI oraz HDMI

Rycina 13. Złącza, odpowiednio od lewej: DVI oraz HDMI

Licencja: public domain. Źródło: wikipedia.org

Ponieważ większość telewizorów stała się w pełni cyfrowa, granica pomiędzy monitorem a telewizorem zatarła się, tak jak to miało miejsce na początku lat osiemdziesiątych. Obecnie dostępne są relatywnie tanie, 42-calowe płaskie ekrany HD, które można swobodnie podłączyć do komputera, co wydawało się niewyobrażalne jeszcze w latach 40. ubiegłego wieku.

Źródła

- Edwards, B. (2019). [VC&G Anthology] The Evolution of Computer Displays. Vintage Computing and Gaming. Available at: http://bit.ly/antologyVCG

Eh…. szkoda, sporo pracy włożone – ale występuje tutaj duży bałagan. Jakie kryteria zostały założone przy opisach tych ekranów? – monitory kompozytowe?? jest mnóstwo monitorów RGM z wejściem kompozytowym. Maszyna elektroniczna? – to era znacznie późniejsza niż teletype. To tylko początek

Dziękuję za uwagi. Nie każda uwaga jest konstruktywna. Nie myli się ten, kto nic nie robi. Moja wiedza na pewno nie jest tak duża jak „Muzeum Komputerów”. Wielka szkoda, że nie mam szans „dotknąć” każdego z tych eksponatów.